Fabulações Algorítmicas

A Fundação Biblioteca Nacional, em parceria com o VFXRio, realiza a série mensal de encontros Fabulações Algorítmicas, um espaço de reflexão sobre os impactos da inteligência artificial e das tecnologias emergentes nas artes, na cultura e na linguagem.

Voltado a um público amplo e interdisciplinar, o ciclo promove o diálogo entre especialistas, pesquisadores, artistas, filósofos, tecnólogos e outros agentes culturais, incentivando o pensamento crítico sobre os futuros possíveis das tecnologias.

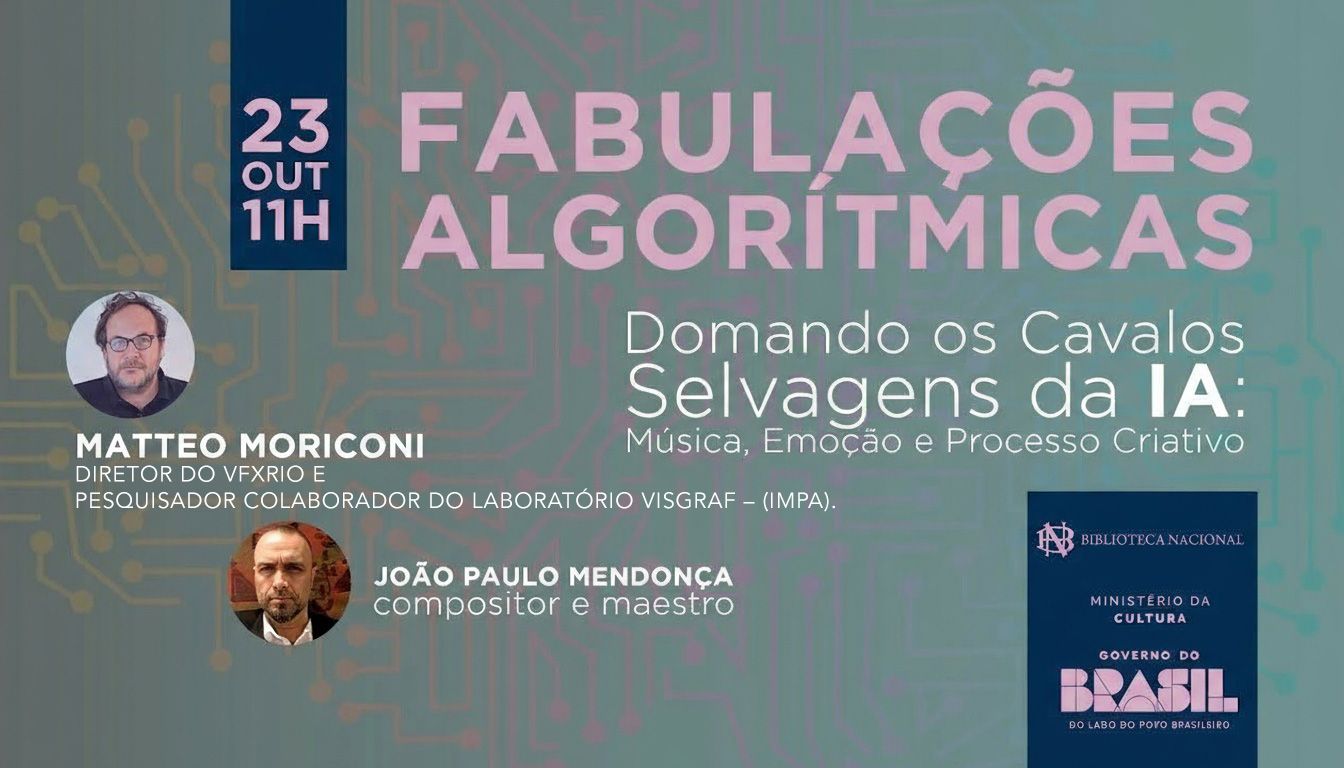

Com mediação de Matteo Moriconi (Associação Brasileira de Tecnologia Visual – VFXRio / Laboratório Visgraf – IMPA), os encontros contam com a participação de convidados de destaque no cenário nacional e internacional. As conversas são transmitidas ao vivo, com acesso gratuito ao público, reforçando o papel da Biblioteca Nacional como centro de pensamento e difusão cultural no Brasil.

Domando os Cavalos Selvagens da IA: Música, Emoção e Processo Criativo

23 de outubro – 2025, às 11h00 (Horário de Brasília)

Tema: Domando os Cavalos Selvagens da IA: Música, Emoção e Processo Criativo

Data: 23 de outubro – 2025, às 11h00 (Horário de Brasília)

Resumo: integração da inteligência artificial aos processos criativos na música e nas artes audiovisuais, o convidado especial é João Paulo Mendonça | Compositor e Maestro, conhecido por seu trabalho na TV Globo, no cinema e no teatro, além de suas experimentações em música eletrônica e trilhas sonoras. Abordará as transformações na composição e na performance musical na era dos sistemas generativos, refletindo sobre como a IA pode ampliar, e ao mesmo tempo desafiar, os limites da criação artística.

Processos Criativos, Democratização e Linguagem na Era da IA

05 de setembro – 2025, às 15h30 (Horário de Brasília)

Veja aqui:

https://vimeo.com/1116309325

Tema: Processos Criativos, Democratização e Linguagem na Era da IA

Data: 05 de setembro – 2025, às 15h30 (Horário de Brasília)

Resumo: impactos da inteligência artificial na criação artística, nas linguagens e nos modos de produção cultural, a convidada especial é Liana Brazil | Sócia – Fundadora e Diretora Criativa da SuperUber, abordará as mudanças na autoria e na coautoria artística na era dos sistemas generativos. A mediação será feita por Matteo Moriconi, coordenador da série e Diretor da Associação Brasileira de Tecnologia Visual (VFXRio) e Pesquisador do Laboratório Visgraf – Instituto de Matemática Pura e Aplicada (IMPA).

Liana Brazil: Diretora Criativa da SuperUber, Liana é co-fundadora da SuperUber (2002), onde atua como diretora criativa e curadora. Foi curadora de festivais como a Bienal Mundial de Criatividade e o Festival Rio2C. Na SuperUber, ela cria experiências que vão desde instalações individuais a museus e festivais, e expõe seu trabalho ao redor do mundo em locais e eventos como a ONU, o Frost Science Museum e o SxSW Festival (EUA), o London Design Museum e o Victoria & Albert Museum (Inglaterra). No Brasil, participou de projetos como o Museu do Amanhã, o Museu da Língua Portuguesa e a Cerimônia de Encerramento dos Jogos Olímpicos Rio 2016. Participou recentemente da criação do Memorial do Holocausto Rio, e do cenário da turnê “Nós, A Gente” da Família Gil. Liana publicou artigos e um livro sobre novas mídias e tem formação em Arquitetura e Urbanismo pela UFRJ, com mestrado em Mídias Interativas pela NY University.

Arte Artificial – Uso Criativo e Autoral de IA no Audiovisual

25 de agosto – 2025, às 15h30 (Horário de Brasília)

Veja aqui a gravação:

https://vimeo.com/1113045135

Fabulações Algorítmicas: Arte Artificial – uso criativo e autoral de IA no audiovisual

Data: 25 de agosto – 2025, às 15h30 (Horário de Brasília)

Resumo: a mesa-redonda aborda o uso criativo e autoral da inteligência artificial no audiovisual, explorando como essas tecnologias estão transformando processos artísticos, narrativas e experiências imersivas. Participação de Nelson Porto, artista visual e especialista em Realidade Virtual, com mediação de Matteo Moriconi, diretor da Associação Brasileira de Tecnologia Visual (VFXRio) e pesquisador do Laboratório Visgraf – Instituto de Matemática Pura e Aplicada (IMPA).

Nelson Porto: Nascido no Rio de Janeiro em 1978, é um artista visual que utiliza fotografia e tecnologia como bases criativas para explorar novas narrativas e interações com a realidade. Especialista em Realidade Virtual, participou do documentário Awavena (Emmy, 2020) e co-criou a exposição XR Tinta & Fogo sobre as pinturas rupestres da Serra da Capivara, vencedora dos prêmios de melhor VR nos festivais Laval Virtual e Cinequest (França). Desde 2019, dedica-se ao uso de IA Generativa para audiovisual, desenvolvendo workflows personalizados e participando de produções de Cinema e Visual Mapping. Seus trabalhos já foram expostos na SP Arte 2021 (Bianca Boeckel Galeria) e na Brisa Galeria (Lisboa, 2022). Tem ampla experiência como professor e palestrante em eventos como Rio2C, POW Festival, Rio Innovation Week, e para instituições como Sebrae, agência Tátil, Sindicato da Indústria Audiovisual do Paraná, ECO-UFRJ, MIS-RJ e Festival Curta Cinema. Desde maio de 2024, é editor de IA do canal Meio, onde desenvolve processos com IA para imagem e vídeo, escreve artigos sobre o tema e leciona nos cursos de IA do canal.

Impactos da Inteligência Artificial nas Artes, Cultura e Ciência

09 de julho de 2025

Veja aqui a gravação:

https://vimeo.com/1100280574

Fabulações Algorítmicas: Impactos da Inteligência Artificial nas Artes, Cultura e Ciência

Data: 09 de julho de 2025

Resumo: A Fundação Biblioteca Nacional e o VFXRio realizaram o evento “Fabulações Algorítmicas: Impactos da Inteligência Artificial nas Artes, Cultura e Ciência” — um espaço de reflexão filosófica sobre as convergências e os novos caminhos abertos pela inteligência artificial. O evento aconteceu no dia 09/07, em formato digital, com transmissão ao vivo pelo canal da FBN no YouTube. O presidente da Biblioteca Nacional, Marco Lucchesi, recebeu os convidados Luiz Velho e Matteo Moriconi para um debate sobre os impactos e as possibilidades da IA.

Luiz Velho: Pesquisador PQ Sênior do CNPq, professor titular do IMPA e cientista líder do Laboratório VISGRAF. Sua formação acadêmica inclui: Anáise de Sistemas pela PUC-Rio, BE em Desenho Industrial pela ESDI – UERJ, MS em Computação Gráfica pelo MIT / Media Lab, e PhD em Computer Science pela University of Toronto. Realizou o primeiro filme de animação por computador na America Latina. Foi artista visitante no National Film Board do Canada, desenvolvedor de sistemas na Fantastic Animation Machine em Nova York, engenheiro principal na Rede Globo, e professor visitante no Courant Institute of Mathematical Sciences da NYU. Também foi pesquisador visitante do HP Laboratories e da Microsoft Research China.

Os encontros são mediados por Matteo Moriconi: tecnologista e diretor, co-fundador da VFXRio, festival afiliado à ACM Siggraph dedicado a fomentar discussões sobre o ecossistema de tecnologias visuais emergentes transformadoras com relevância socioeconômica no Brasil. Graduado em Química pela PUC-Rio, Matteo fundou o Museu Virtual de Arte Brasileira em 1997, um projeto pioneiro que utilizou a web para iniciativas criativas, trabalhando em conjunto com diversos artistas latino-americanos na criação de obras virtuais. Matteo possui mais de 20 anos de experiência no desenvolvimento de projetos criativos, incluindo anos de formação nos grupos de tecnologia da Walt Disney Company e da Discovery Channel Europe.